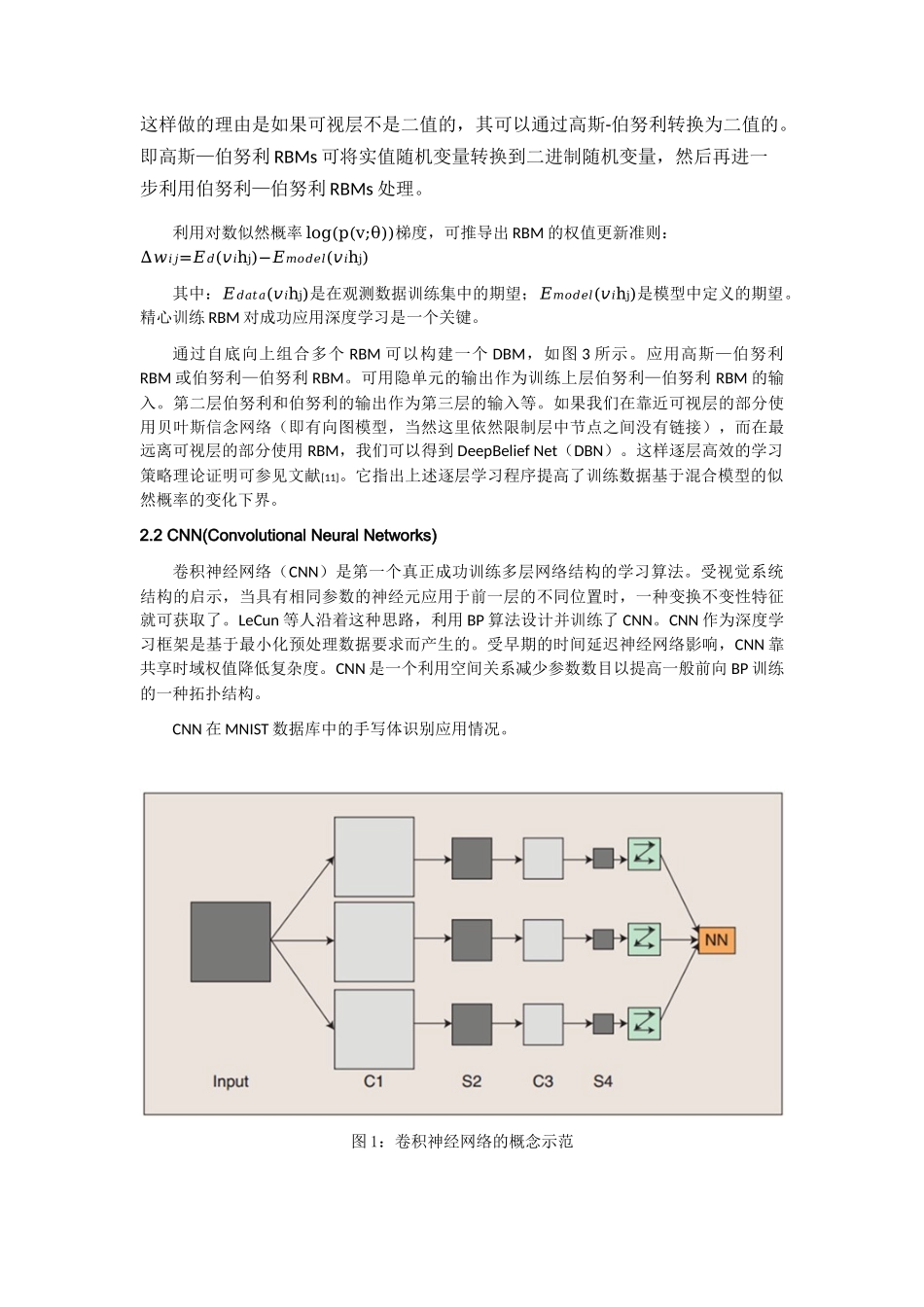

深度学习综述吕倩倩1(兰州大学信息学院,甘肃兰州730000)摘要:深度学习是机器学习领域的一个重要分支,2006年Hinton等人在SCIENCE上发表的文章,引起了深度学习的新浪潮。它的核心思想是大数据和深度模型,目前已经在各个领域中取得了优秀的成果。本文主要包括深度学习的由来,深度学习各个模型的具体算法以及应用现状,深度学习目前面临的机遇和挑战等方面。关键字:深度学习;深信度网络;卷积神经网络;受限玻尔兹曼机Abstract:Deeplearningisanewareaofmachinelearning(ML)research,whichgetsthecomingof“bigdata+depthmodel”,itsmotivationistobuildneuralnetworkthatsimulatesthehumanbraintoanalyzeandlearn.Deeplearninghasalreadymaderemarkableachievementbothinresearchandcommercialareas.Thispaperdiscussedtheoriginofdeeplearning,thenanalyzedvirtuebroughtbydeeplearning.Itintroducedthemainstreamdeeplearningalgorithmandtheirapplications.Finallyitconcludedtheproblemremaininganddevelopmentorientation.Keywords:deeplearning;featurelearning;DBN;CNN;RBM1引言2006年,加拿大多伦多大学教授、机器学习领域的泰斗Hinton和他的学生RuslanSalakhutdinov在《科学》上发表了一篇文章,开启了深度学习在学术界和工业界的浪潮[1]。这篇文章有两个主要观点:1、很多隐层的人工神经网络具有优异的特征学习能力,学习得到的特征对数据有更本质的刻划,从而有利于可视化或分类;2、深度神经网络在训练上的难度,可以通过“逐层初始化”来有效克服,且是通过无监督学习实现的。此外,基于深信度网(DBN)提出非监督贪心逐层训练算法,为解决深层结构相关的优化难题带来希望,随后提出多层自动编码器深层结构。2012年6月,《纽约时报》披露了谷歌的GoogleBrain项目,吸引了公众的广泛关注.这个项目是由著名的斯坦福大学的机器学习教授Ng和在大规模计算机系统方面的世界顶尖专家Dean共同主导,用I6000个CPUCore的并行计算平台训练一种称为“深度神经网络(deepneuralnetworks,DNN)的机器学习模型,在语音识别和图像识别等领域获得了巨大的成功.2012年11月,微软在中国天津的一次活动上公开演示了一个全自动的同声传译系统,讲演者用英文演讲,后台的计算机一气呵成自动完成语音识别、英中机器翻译和中文语音合成,效果非常流畅.据报道,后面支撑的关键技术也是DNN,或者深度学习(deeplearning,DL)L2].2013年的1月,在中国最大的互...