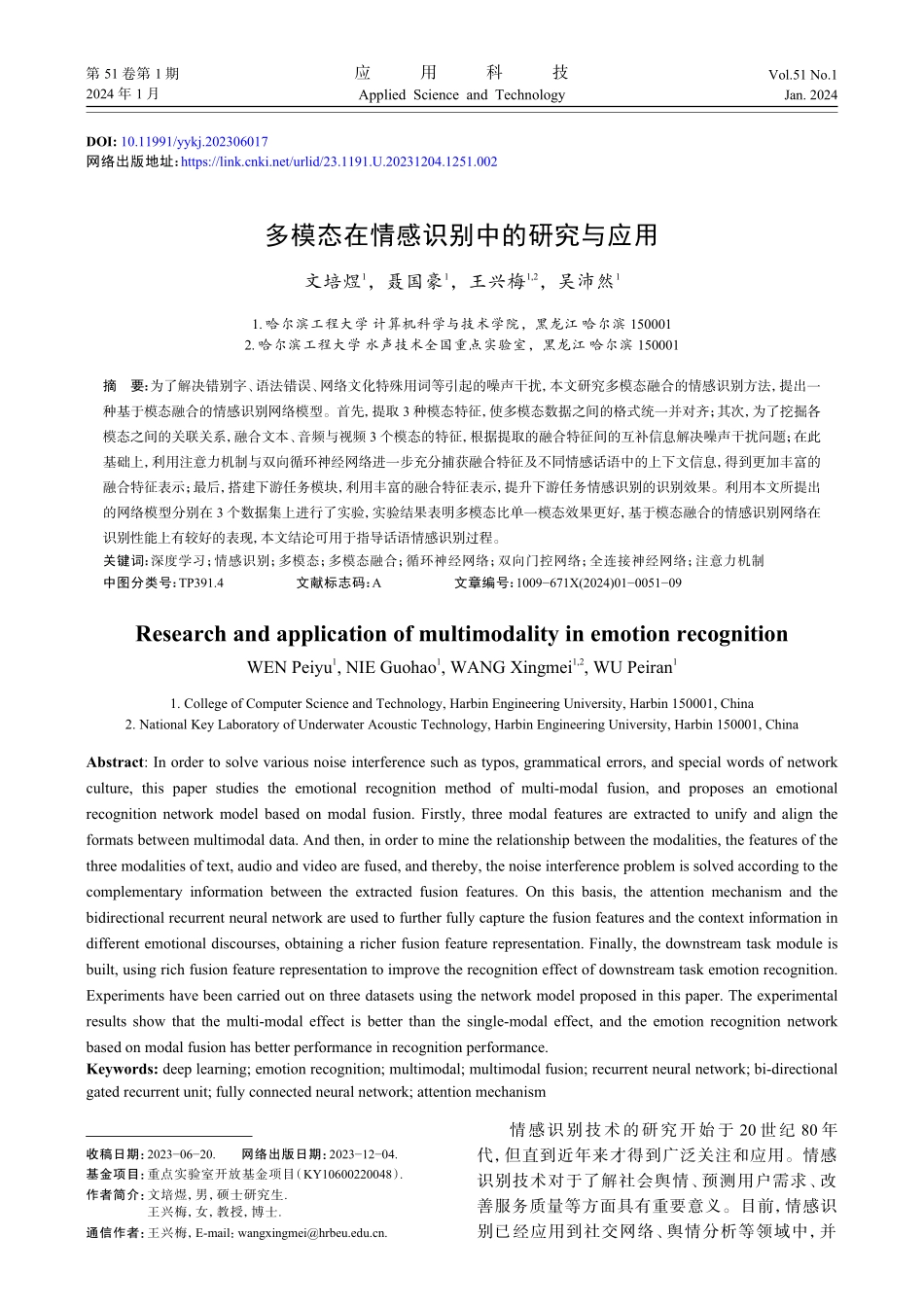

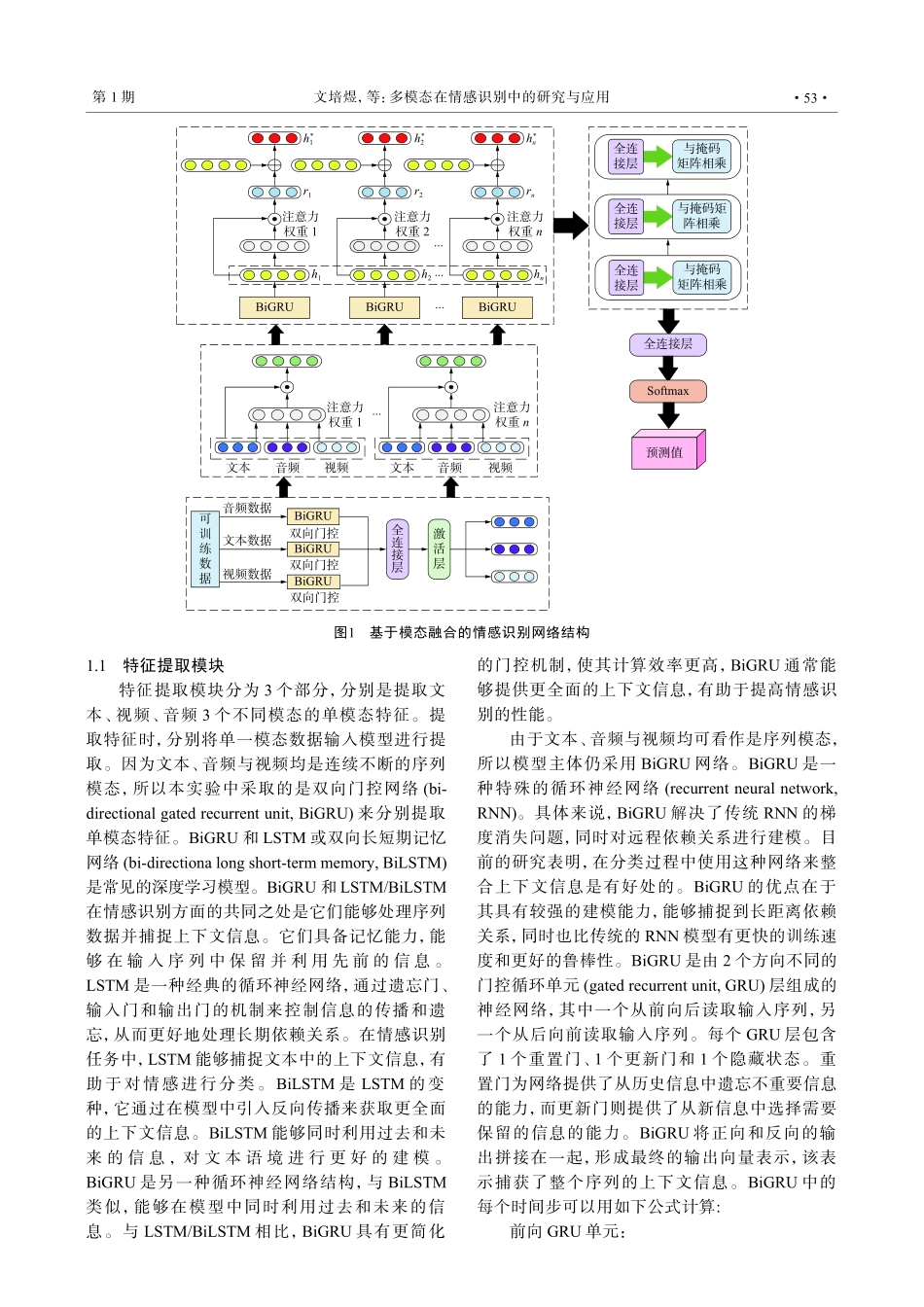

DOI:10.11991/yykj.202306017网络出版地址:https://link.cnki.net/urlid/23.1191.U.20231204.1251.002多模态在情感识别中的研究与应用文培煜1,聂国豪1,王兴梅1,2,吴沛然11.哈尔滨工程大学计算机科学与技术学院,黑龙江哈尔滨1500012.哈尔滨工程大学水声技术全国重点实验室,黑龙江哈尔滨150001摘要:为了解决错别字、语法错误、网络文化特殊用词等引起的噪声干扰,本文研究多模态融合的情感识别方法,提出一种基于模态融合的情感识别网络模型。首先,提取3种模态特征,使多模态数据之间的格式统一并对齐;其次,为了挖掘各模态之间的关联关系,融合文本、音频与视频3个模态的特征,根据提取的融合特征间的互补信息解决噪声干扰问题;在此基础上,利用注意力机制与双向循环神经网络进一步充分捕获融合特征及不同情感话语中的上下文信息,得到更加丰富的融合特征表示;最后,搭建下游任务模块,利用丰富的融合特征表示,提升下游任务情感识别的识别效果。利用本文所提出的网络模型分别在3个数据集上进行了实验,实验结果表明多模态比单一模态效果更好,基于模态融合的情感识别网络在识别性能上有较好的表现,本文结论可用于指导话语情感识别过程。关键词:深度学习;情感识别;多模态;多模态融合;循环神经网络;双向门控网络;全连接神经网络;注意力机制中图分类号:TP391.4文献标志码:A文章编号:1009−671X(2024)01−0051−09ResearchandapplicationofmultimodalityinemotionrecognitionWENPeiyu1,NIEGuohao1,WANGXingmei1,2,WUPeiran11.CollegeofComputerScienceandTechnology,HarbinEngineeringUniversity,Harbin150001,China2.NationalKeyLaboratoryofUnderwaterAcousticTechnology,HarbinEngineeringUniversity,Harbin150001,ChinaAbstract:Inordertosolvevariousnoiseinterferencesuchastypos,grammaticalerrors,andspecialwordsofnetworkculture,thispaperstudiestheemotionalrecognitionmethodofmulti-modalfusion,andproposesanemotionalrecognitionnetworkmodelbasedonmodalfusion.Firstly,threemodalfeaturesareextractedtounifyandaligntheformatsbetweenmultimodaldata.Andthen,inordertominetherelationshipbetweenthemodalities,thefeaturesofthethreemodalitiesoftext,audioandvideoarefused,andthereby,thenoiseinterferenceproblemissolvedaccordingtothecomplementaryinformationbetweentheextractedfusionfeatures.Onth...