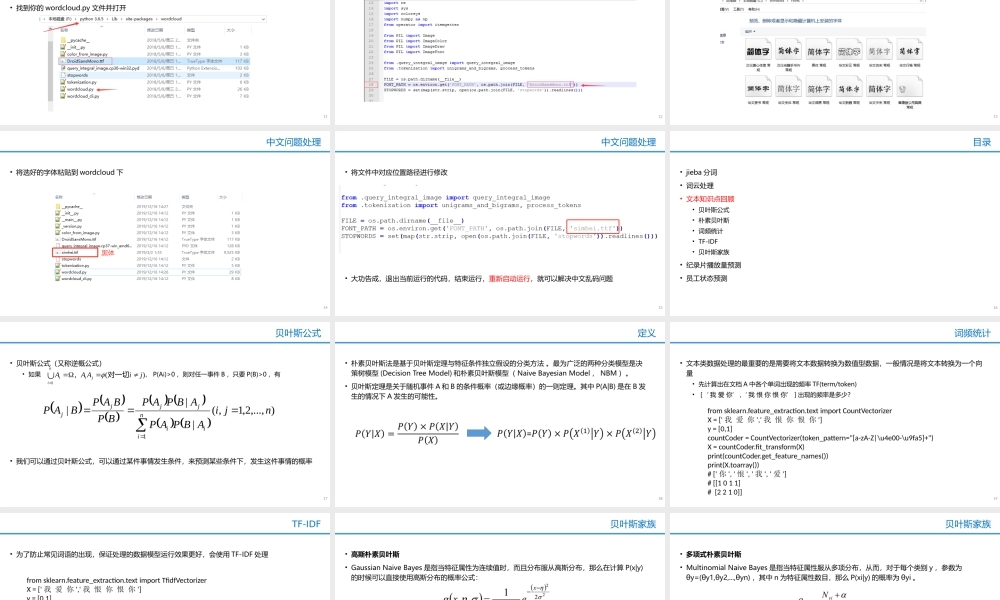

徐idealxuideal@163.com朴素贝叶斯•如何计算预测纪录片播放量?课前甜点2•jieba分词•介绍与安装•分词模式处理•去除停用词•词云处理•文本知识点回顾•纪录片播放量预测•员工状态预测目录3•何为中文分词?认识/你/很/高兴这么做的目的是什么?•目标•方便后续处理,进行特征操作或者词频统计•Python中分分词工具很多,包括盘古分词、Yaha分词、Jieba分词、清华THULAC等。它们的基本用法都大同小异,这里先了解一下结巴分词。•安装•命令窗口输入pipinstalljieba介绍与安装4•结巴中文分词支持的三种分词模式包括:•精确模式:试图将句子最精确地切开,适合文本分析;•jieba.cut(text,cut_all=True)text文本,cutall处理模式,默认为False西方\列强\把\中国\土地\瓜分\了•全模式:把句子中所有的可以成词的词语都扫描出来,速度非常快,但是不能解决歧义问题;•jieba.cut(text,cut_all=False)•jieba.lcut(text)西方\列强\把\中\国土\地瓜\分了•搜索引擎模式:在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词。•jieba.cut_for_search(text)分词模式处理5•停用词•指在信息检索中,为节省存储空间和提高搜索效率,在处理自然语言数据(或文本)之前或之后会自动过滤掉某些字或词,这些字或词即被称为StopWords(停用词)。这些停用词都是人工输入、非自动化生成的,生成后的停用词会形成一个停用词表。•去除的目的•提升无用词,提升模型的计算精度•处理方式•详见代码去除停用词6•jieba分词•词云处理•词云简介•安装及使用•中文问题处理•文本知识点回顾•纪录片播放量预测•员工状态预测目录7•基于Python的词云生成类库,很好用,而且功能强大。•能够显示某个样本中单词的数量,做到可视化的词频统计效果词云简介8•安装:•控制行中输入命令pipinstallwordcloud•常用API•wordcloud=WordCloud(background_color="white",width=1000,height=860,margin=2).generate(f)•background_color背景颜色•width图片宽度•height图片高度•margin边框•generate(f)•按照指定方式生成云•f处理后的字符串安装及使用9importmatplotlib.pyplotaspltplt.imshow(wordcloud)plt.axis("off")plt.show()显示词云wordcloud.to_file(‘test.png’)保存图片安装及使用10•之所以中文无法正常显示,是因为wordcloud默认不支持中文•乱码解决方式•找到你的wordcloud.py文件并打开中文问题处理11•找到需要导入的字体路径部...