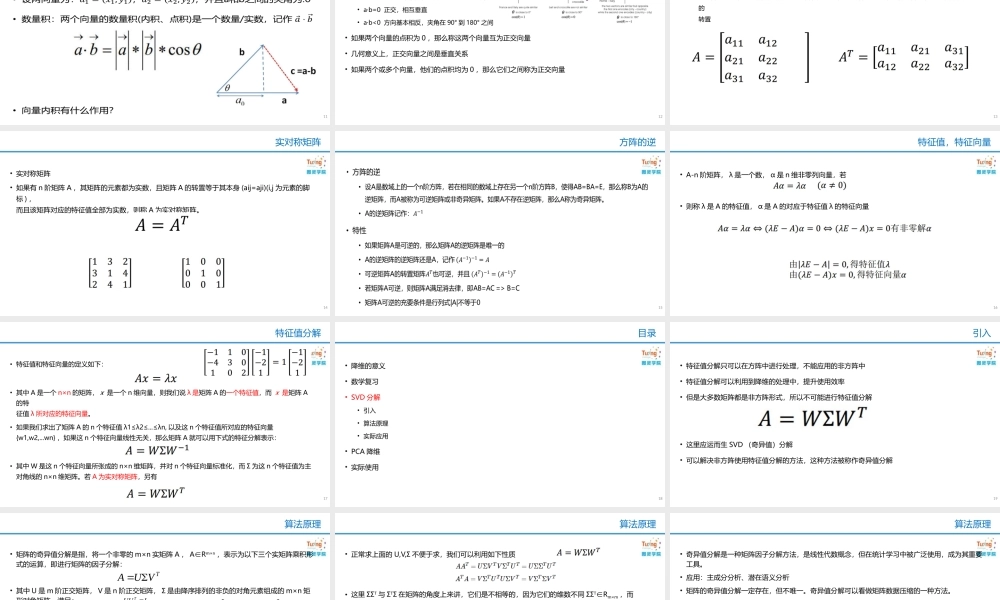

徐idealxuideal@163.com数据降维•降维的意义•数学复习•SVD分解•PCA降维•实际使用目录2•我要找对象!课前甜点3165cm+性感贤惠身材匀称漂亮开朗乐观温柔会打扮会持家会做饭忠诚•降维的意义•背景•问题描述•常见方式•数学复习•SVD分解•PCA降维•实际使用目录4•在数据分析或者推荐算法的应用场景下,注定会使用更多的特征去描述数据,以便收集大量的数据去寻找规律。•更多的特征注定会增加研究准确性。但是在大多数情况下,许多特征之间存在关系,从而增加了模型的复杂性,对数据分析带来不便。如果对每个特征进行分析,信息会被孤立。而且减少特征信息,也很容易产生错误的结论。•为了能够减少分析特征的同时,又尽量减少原指标的信息损失,对收集的数据进行全面的分析。由于各变量间存在一定的相关关系,因此有可能用较少的综合指标分别综合存在于各变量中的各类信息。主成分分析与因子分析就属于这类降维的方法。背景5•分析一下下表中的主成分是什么?问题描述6•再来分析它的?问题描述7•使用降维技术,将维度降低,可以更好的分析出想要的内容•感谢博客http://blog.csdn.net/zhongkelee/article/details/44064401问题描述8•奇异值分解(SVD,singularvaluedecomposition)对矩阵最好的分解形式•主成分分析(PCA,Principalcomponentsanalysis)设定最大方差可以显示数据特征•低维嵌入MDS算法:降维前后保证样本点的距离相等•等度量映射—Isomap:高维空间的分布虽然极为复杂,但是在局部上,仍然具有欧式空间的性质•线性判别分析——LDA:有监督学习的降维技术,投影后类内方差最小,类间方差最大常见方式9•降维的意义•数学复习•向量内积•矩阵的转置•实对称矩阵•方阵的逆•特征值,特征向量•特征值分解•SVD分解•PCA降维•实际使用目录10•向量内积11•通过内积可以判断两个数据信息之间的相关性•a·b>0方向基本相同,夹角在0°到90°之间•a·b=0正交,相互垂直•a·b<0方向基本相反,夹角在90°到180°之间•如果两个向量的点积为0,那么称这两个向量互为正交向量•几何意义上,正交向量之间是垂直关系•如果两个或多个向量,他们的点积均为0,那么它们之间称为正交向量向量内积12•矩阵的转置•把矩阵A的行和列互相交换所产生的矩阵称为A的转置矩阵,这一过程叫做矩阵的转置。使用/表示A的转置矩阵的转置13•实对称矩阵•如果有n阶矩阵A,其矩阵的元素都为实数,且矩阵A的转置等于其本身(aij=aji)(i,j为元素的...