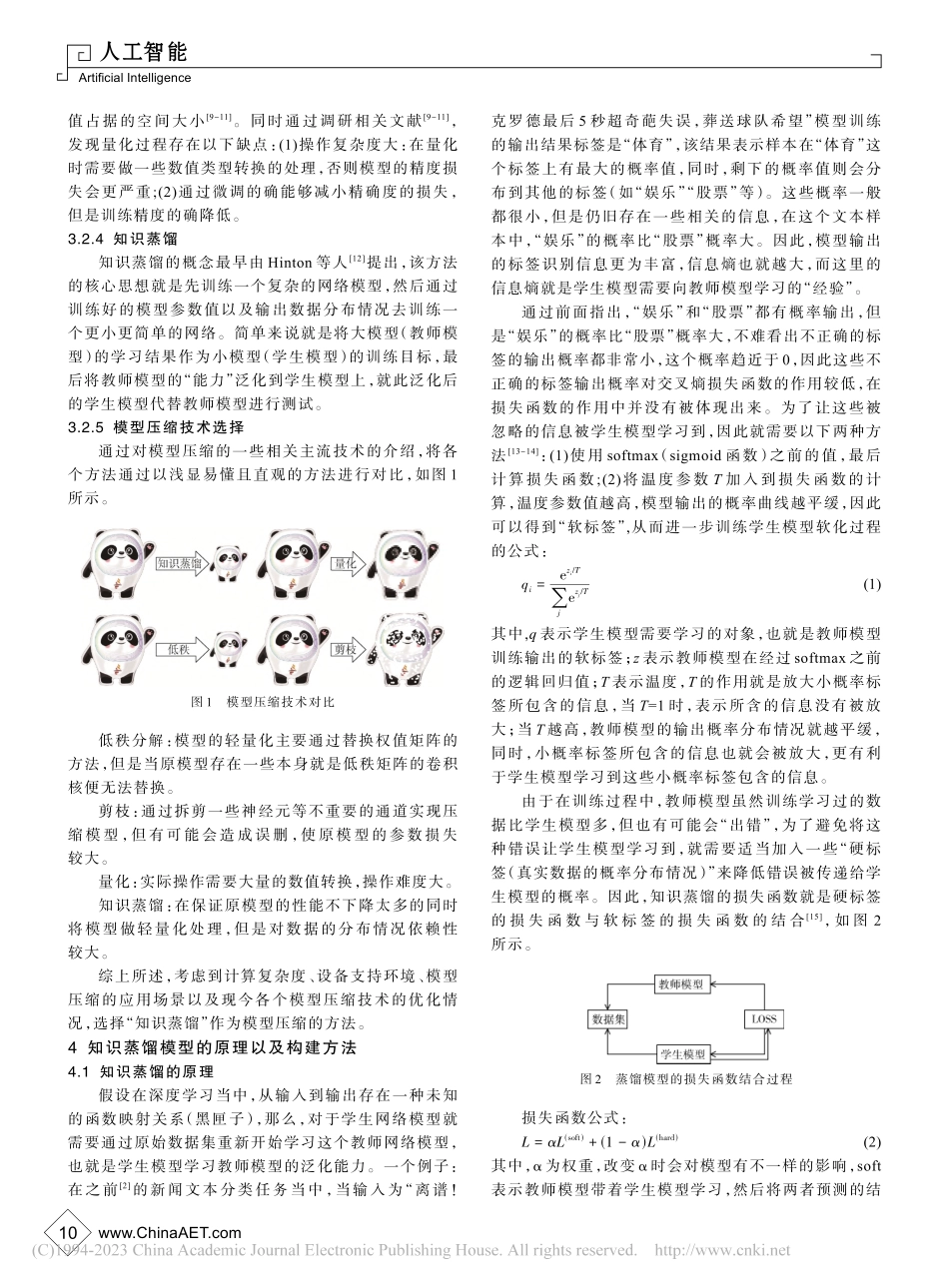

www.ChinaAET.comArtificialIntelligence人工智能基于BERT-CNN的新闻文本分类的知识蒸馏方法研究*叶榕,邵剑飞,张小为,邵建龙(昆明理工大学信息工程与自动化学院,云南昆明650500)摘要:近年来,随着大数据时代进入人类的生活之后,人们的生活中出现很多无法识别的文本、语义等其他数据,这些数据的量十分庞大,语义也错综复杂,这使得分类任务更加困难。如何让计算机对这些信息进行准确的分类,已成为当前研究的重要任务。在此过程中,中文新闻文本分类成为这个领域的一个分支,这对国家舆论的控制、用户日常行为了解、用户未来言行的预判都有着至关重要的作用。针对新闻文本分类模型参数量多和训练时间过长的不足,在最大限度保留模型性能的情况下压缩训练时间,力求二者折中,故提出基于BERT-CNN的知识蒸馏。根据模型压缩的技术特点,将BERT作为教师模型,CNN作为学生模型,先将BERT进行预训练后再让学生模型泛化教师模型的能力。实验结果表明,在模型性能损失约2.09%的情况下,模型参数量压缩约为原来的1/82,且时间缩短约为原来的1/670。关键词:新闻文本;BERT;CNN;知识蒸馏中图分类号:TP391.1文献标志码:ADOI:10.16157/j.issn.0258-7998.223094中文引用格式:叶榕,邵剑飞,张小为,等.基于BERT-CNN的新闻文本分类的知识蒸馏方法研究[J].电子技术应用,2023,49(1):8-13.英文引用格式:YeRong,ShaoJianfei,ZhangXiaowei,etal.KnowledgedistillationofnewstextclassificationbasedonBERT-CNN[J].ApplicationofElectronicTechnique,2023,49(1):8-13.KnowledgedistillationofnewstextclassificationbasedonBERT-CNNYeRong,ShaoJianfei,ZhangXiaowei,ShaoJianlong(SchoolofInformationEngineeringandAutomation,KunmingUniversityofScienceandTechnology,Kunming650500,China)Abstract:Inrecentyears,aftertheeraofbigdatahasenteredhumanlife,manyunrecognizabletext,semanticandotherdatahaveappearedinpeople'slives,whichareverylargeinvolumeandintricateinsemantics,whichmakestheclassificationtaskmoredifficult.Howtomakecomputersclassifythisinformationaccuratelyhasbecomeanimportanttaskofcurrentresearch.Inthisprocess,Chinesenewstextclassificationhasbecomeabranchinthisfield,whichhasacrucialroleinthecontrolofnationalpublicopinion,theunderstandingofusers'dailybehavior,andthepredictionofuse...