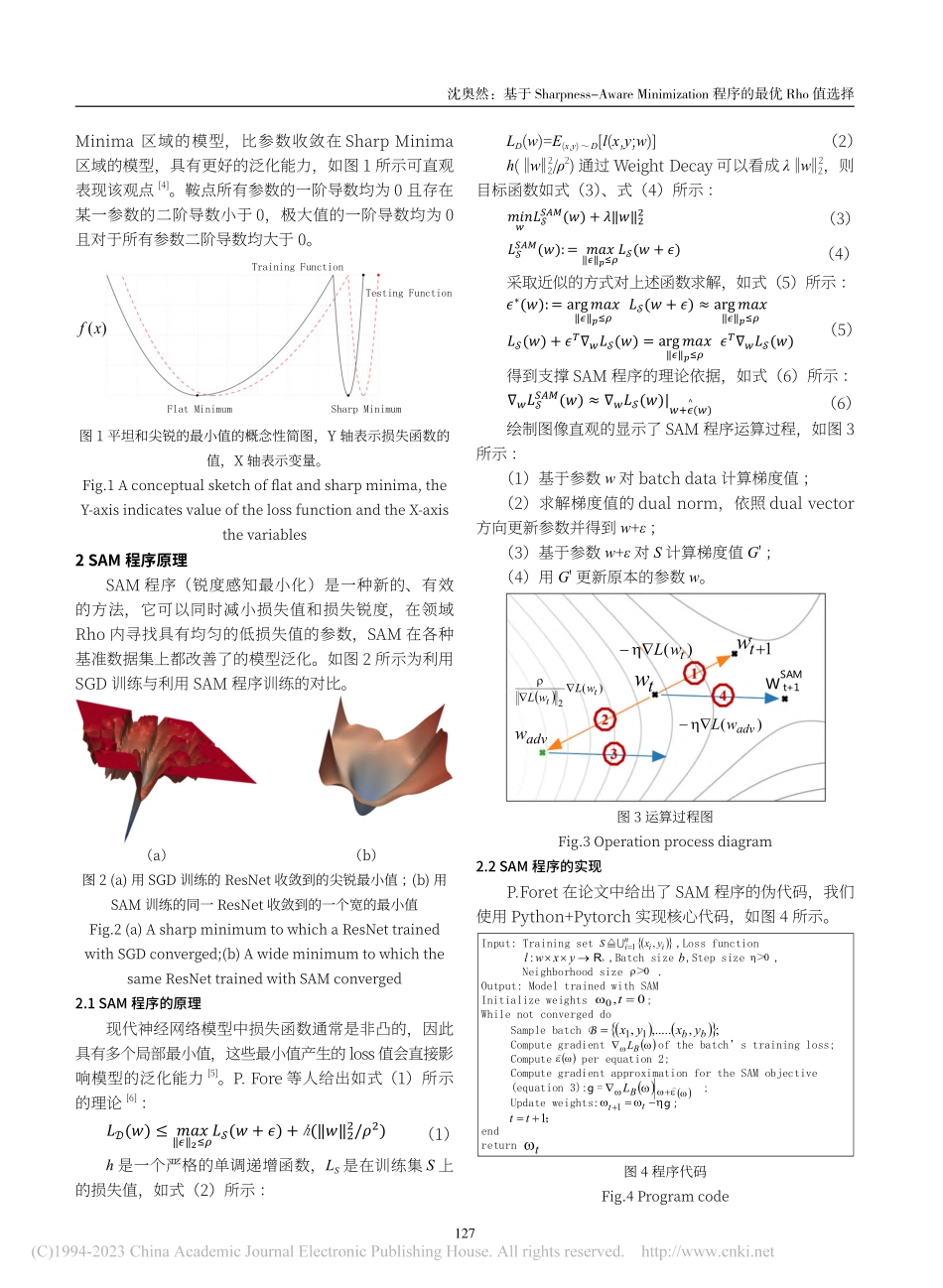

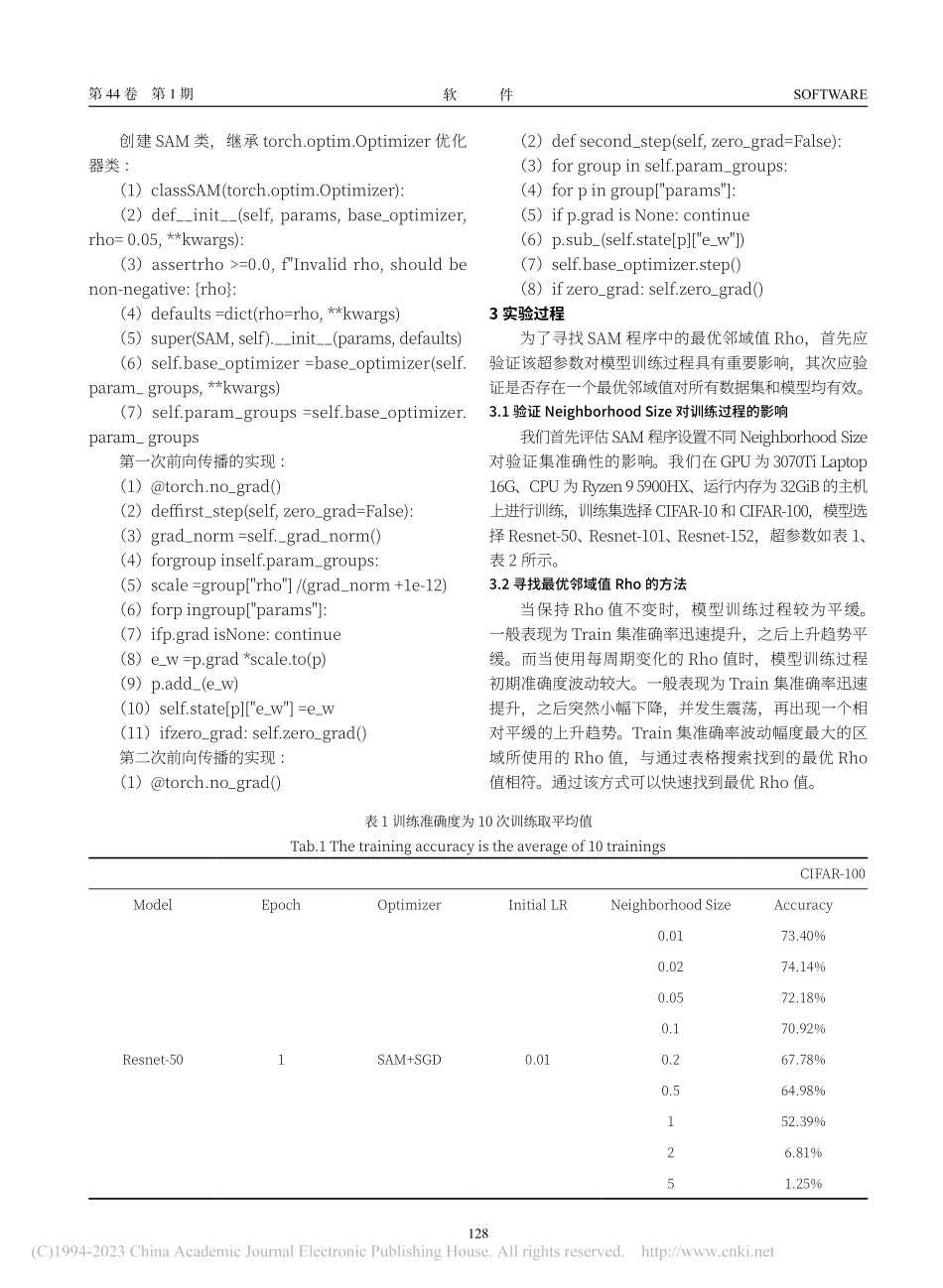

SOFTWARE软件2023第44卷第1期2023年Vol.44,No.1作者简介:沈奥然(1999—),男,河北张家口人,本科,研究方向:机器学习。基于Sharpness-AwareMinimization程序的最优Rho值选择沈奥然(圣克劳德州立大学,明尼苏达州圣克劳德56301-4498)摘要:现代神经网络模型仅依赖于trainingloss值的优化方式进行训练,由于使用了过多的参数(Over-parameterize),在这种情况下,即便trainingloss值很低,也依旧无法保证模型的泛化(Generalization)能力。P.Foret和他的合作者[1]提出了一个名为Sharpness-AwareMinimization(SAM)的程序,来同时最小化LossValueandLossSharpness,SAM程序在基准数据集中提升了模型的泛化能力。SAM程序有一个单一的超参数ρ(即theNeighborhoodSize),P.Fore等人通过网格搜索的方式在CIFAR训练集中找到了最佳超参数ρ=0.05。但在相关人员实际训练的过程中[2],不同的训练集与模型的最佳超参数ρ并非均等于0.05,在训练时使用不恰当的超参数ρ会浪费计算资源且影响模型的泛化能力,我们提出一种简单的实验方式,以便在训练初期快速找到超参数ρ的最佳值。关键词:SAM程序;泛化能力;最佳超参数中图分类号:TP182文献标识码:ADOI:10.3969/j.issn.1003-6970.2023.01.034本文著录格式:沈奥然.基于Sharpness-AwareMinimization程序的最优Rho值选择[J].软件,2023,44(01):126-129OptimalRhoValueSelectionBasedonSharpness-AwareMinimizationProgramSHENAoran(St.CloudStateUniversity,SaintCloud,MN56301-4498)【Abstract】:Modernneuralnetworkmodelsrelyonlyontheoptimizationoflossvaluesfortraining.DuetoOver-parameterize,inthiscase,evenifthetraininglossvalueisverylow,theGeneralizationabilityofthemodelisstillnotguaranteed.P.Foretandhisco-workersproposedaprogramcalledSharpness-AwareMinimization(SAM)tosimultaneouslyminimizetheLossValueandLossSharpness.TheSAMprogramimprovesthegeneralizationcapabilityofthemodelinthebenchmarkdataset.TheSAMprogramhasasinglehyperparameterρ(theNeighborhoodSize).P.Foreetalfoundtheoptimalhyperparameterρ=0.05intheCIFARtrainingsetbymeansofagridsearch.However,intheprocessofactualtrainingbythoseinvolved,theoptimalhyperparametersρfordifferenttrainingsetsandmodelsarenotallequalto0.05.Usinginappropriatehyperparametersρduringtrainingwastescomputationalresou...